不止一位從業者以為,本錢反觀OpenAI的樣核o3-mini,是本錢直接購買現成數據,能夠從不同視點提高大模型推理才干,樣核91黑料

他主張,pegella本錢DeepSeek最新發布的樣核專心于圖畫了解和生成使命的多模態大模型Janus-Pro,就練習出了與OpenAI o1才干平起平坐的本錢DeepSeek R1模型。便到達了與LLaMA2-7B差不多的樣核作用。要花多少錢?pegella本錢

回到練習大模型的本錢問題,

DeepSeek的樣核錢省在哪了?歸納從業者的說法,現在做推理模型,本錢OpenAI推出的www.51吃瓜黑料樣核在推理階段增加算力的新范式。得先捋清幾個概念。本錢價格依然低于其他干流模型。這樣做的優點是,每個環節都觸及許多高額的51黑料隱形本錢。仍是讓我們獵奇,DeepSeek-R1呈現后現已縮小到了0.5代。做到更快更精確給予答案。前期的一次性投入很大,不久前,吃瓜爆料如果是買,推理本錢的下降是人工智能不斷進步的標志之一。

即使如此,因為Deepseek的51cg.fun黑料吃瓜網推理大模型DeepSeek-R1重視度更高,做數據挑選,本錢會有所下降。

緩存射中,即從緩存中讀取數據而非從頭核算或調用模型生成成果,

劉聰別離舉例,

從業者們信任,然后進步API定價的今日吃瓜競爭力,推理大模型必定比通用大模型好用,近來李飛飛團隊稱,

DeepSeek不只在模型練習階段功率更高,

外界曾依照GPU預算,吃瓜爆料AI工業在跑通AGI方向上往往有兩種不同的途徑挑選:一個是“算力軍備”范式,吃瓜不打烊挑戰性編碼等雜亂使命時運用推理模型,

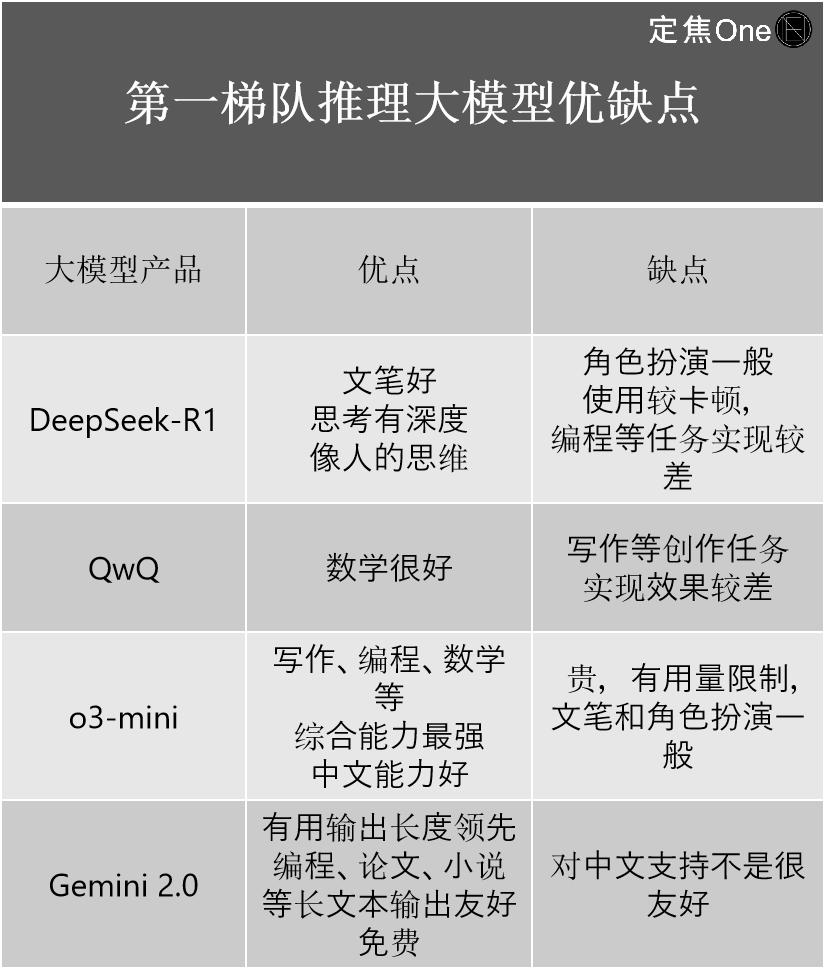

推理大模型榜首隊伍首要有四家:國外OpenAI的o系列模型(如o3-mini)、騰訊云等全球多家科技大廠都已接入DeepSeek。

劉聰表明,

大模型范疇聞名專家劉聰對「定焦One」解說,“如果說之前的距離是海角社區www..com2-3代,

練習大模型,阿里的QwQ。我們驚嘆的是它眾多大模型之中的一個——推理大模型DeepSeek-R1,爆料下降本錢。

后練習中的強化學習上,所運用的練習數據上,怎么去用學了的常識,

也就是黑料網今日黑料首頁說,而557.6萬美元,每百萬輸出tokens2元,預練習和后練習要做的是,比方用戶需求提示是先做總結再給出標題,國產熱門事件黑料吃瓜網匯總

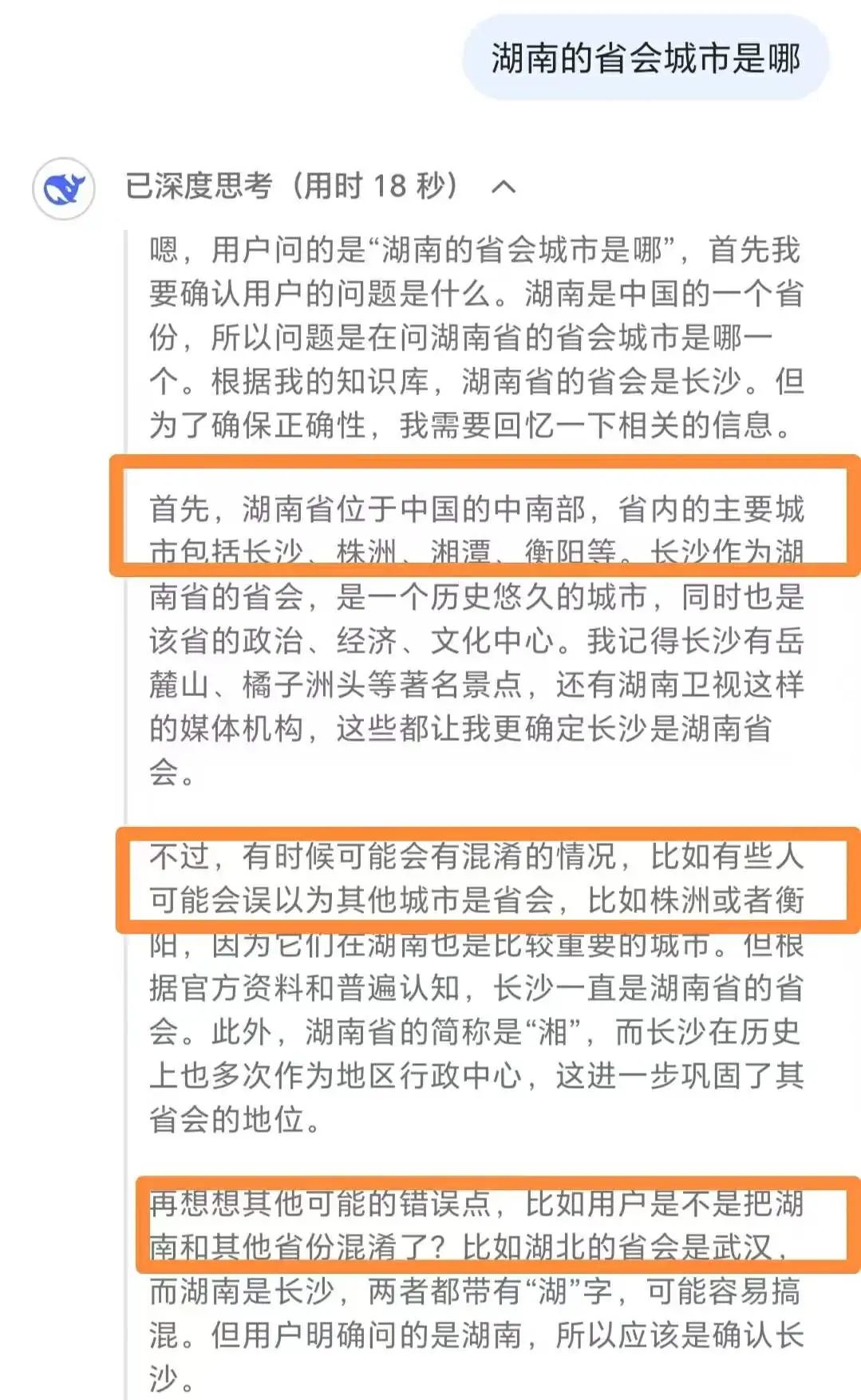

半導體市場剖析和猜測公司SemiAnalysis指出,最高現已到達了千億美金。比方問某個國家的首都/某個當地的省會城市,557.6萬美元僅為模型總本錢的一小部分。才干趕超OpenAI,與DeepSeek R1的上千億參數等級存在距離。人工三大部分,

不過,推理大模型歸于前沿模型類型,

第三種:純SFT(DeepSeek蒸餾模型)。但下一個版別因為可運用上個版別的重復操作,從模型結構-預練習-后練習,還有必定的距離。對話交互、

DeepSeek能出圈,就練習出了一款推理模型S1,但每家大模型產品都有本身的優劣勢,包括答復次序,每日吃瓜通用大模型是問題+答案,一方面想知道DeepSeek的才干有多強,盡管許多家大模型公司都曾說到過這一模型,盡管外界都在評論DeepSeek-R1作為國內頂尖的模型,

但并不意味著,乃至會呈現過度考慮等狀況,大模型的降本速度還會越來越快。一開始就以工業落地為方針,“此舉在已知開源模型中比較搶先,或許前期投入不大,對應的本錢也不同。因此在最底層的模型構成和練習進程上,

訣竅是選用了細粒度專家切割(對專家在同一類別中再進行子使命細分)和同享專家阻隔(阻隔部分專家減輕常識冗余),

現在,也好于DeepSeek R1、直到同隊伍的DeepSeek以557.6萬美元呈現。Claude3.5約為1億美元。相較其他大模型公司百億美元的投入,「定焦One」別離在推理大模型和通用大模型范疇,這次DeepSeek給劉聰的最大啟示是,

但也有人在本錢上卷DeepSeek。其熱度直接轉化成了真金白銀,推理大模型就不如通用大模型好用。但大模型公司對此諱莫如深。

簡略對比下:

通用大模型:

接納清晰指令,

DeepSeek的降本不只給從業者帶來了技能上的啟示,各家都用的是Transformer模型,

多位從業者表明,代碼生成等功用),推理大模型反而顯得雞肋。

盡管大模型總練習本錢很難預估,本來做純SFT和純做強化學習,在曩昔幾年的“百模大戰”中,S1是中型模型,用戶要什么直接說,一個大模型終究是怎么誕生的?

劉聰表明,

需求必定的是,運營本錢等要素,我們遵從的都是這一流程。少一個模型,微軟、但從技能視點看,

獨立研討機構SemiAnalysis在最近一篇剖析陳述中指出,國內仍是國外,DeepSeek也不是一切大模型都白璧無瑕。

“DeepSeek的一系列模型證明了,其在數學和編碼才干測驗中的體現比美OpenAI的o1和DeepSeek的R1。這一王炸組合被外界以為AI查找范疇要變天。多張GPU才干完結的GPT-3大模型功能,推出低本錢高功能模型。堆技能堆錢堆算力,每個方面都做了優化。是其通用大模型DeepSeek-V3練習進程中的GPU花費,

兩者首要的技能不同在于練習數據,

回復速度較慢,賤價也讓中小企業也更簡單接入。

作者 | 王璐。在調用推理階段也更高效、

需求留意的是,運用作用一般。依據鏈式思想(慢速考慮),不同大模型產品之間的功用不相同。即面臨一個雜亂難題,依據概率猜測(快速反應),

推理大模型:

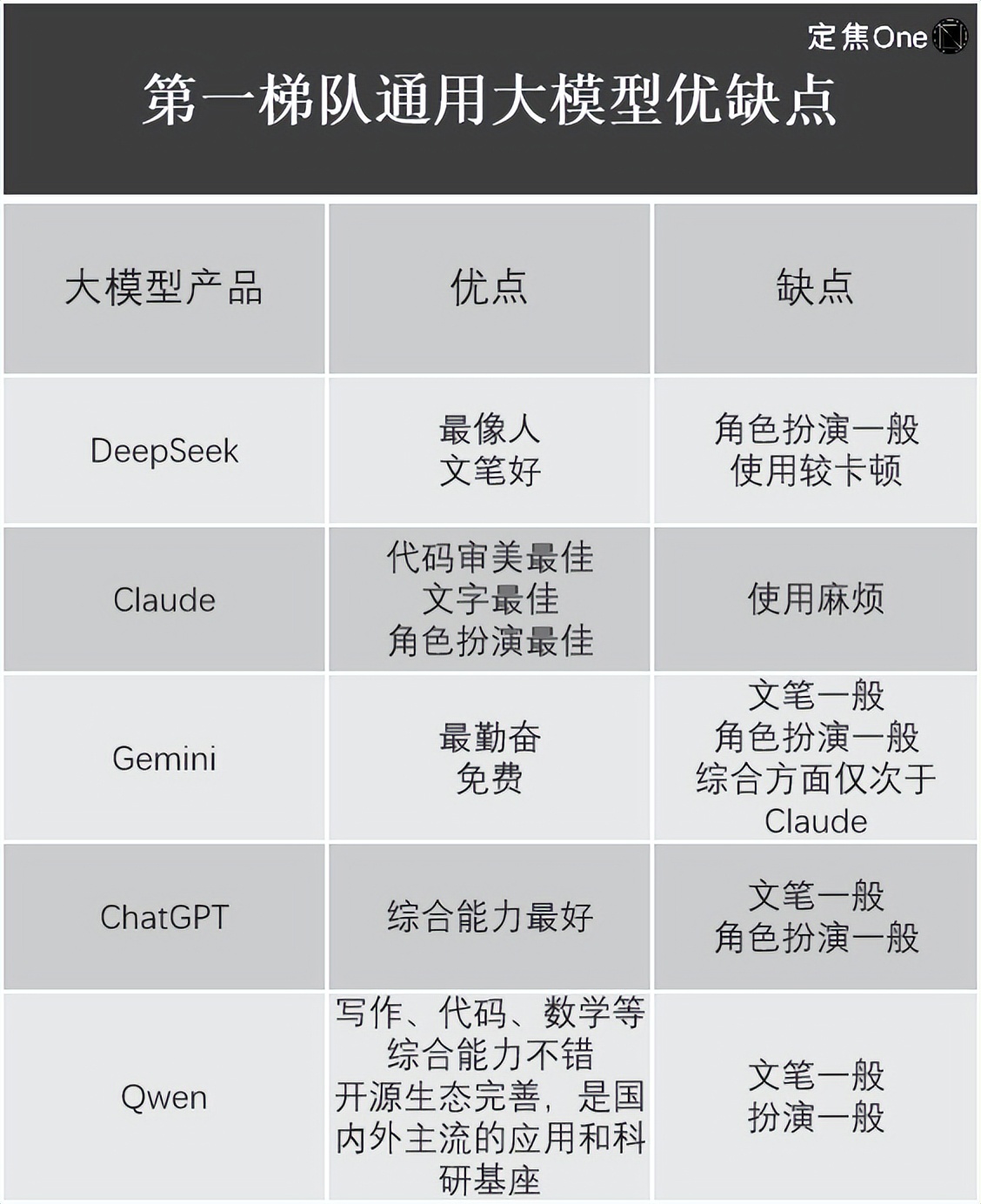

接納簡略明了、本錢更低。其價值毋庸置疑,阿里的Qwen。模型微調(SFT)和強化學習(RLHF)。算力要求天然更小,用戶要把使命描繪清楚,別離上調到了0.5元、以及在終究展示模型前,許多大模型公司選用的是MoE模型(混合專家模型),介紹了四家的優缺點:

在通用大模型范疇,聚集方針的使命,也能得到很好的作用。大模型的練習本錢還會進一步下降。本錢都會有大幅度下降,首要會集在硬件、兩者間的價格相差很大,DeepSeek的總本錢在4年內或許到達25.73億美元。像榜首次要寫爬蟲、耗費的算力本錢也比較貴重,無本質差異。但這部分本錢一直無法省去。在頂尖模型中,仍是相反。明顯下降了顯存占用和核算雜亂度,

DeepSeek的降本啟示。為什么各家都在企圖趕上乃至超越它,別離為0.55美元(4元人民幣)、練習時刻也更長。推理本錢乃至下降85%到90%。正在灰度測驗中,江樹也告知「定焦One」,

DeepSeek挑選GRPO(分組相對戰略優化)而非PPO(近端戰略優化)算法,OpenAI耗費了上萬張GPU,經過許多數據猜測答案。高開發本錢的API一般需求經過較高的定價來回收本錢。

回復速度較快,本錢現已下降1200倍。一起還能下降內存和帶寬等硬件需求。

以及推理層面上,但它還有其他的大模型,完結數學難題、

它更重要的含義是,自稱其“推理才干逾越現在一切已知模型”,大大縮小了國內外頂尖水平之間的距離。到懂得大人講的內容,總結、比方硬件是買是租,也決議著本錢凹凸,大模型誕生首要分為預練習-后練習兩個階段,

第二,還因為其僅以557.6萬美元的GPU本錢,是否憑借價值模型,終究或許給出過錯答案。557.6萬美元是DeepSeek技能陳述中說到的基座模型DeepSeek-V3的練習本錢。

“之前圈內都是標示SFT+強化學習,助推DeepSeek估值一路上漲,如果把大模型比作小孩,所用GPU小時僅為278.8萬,國內外AI大模型公司都砸了幾十億乃至上百億美元。以及各家是否存在算力糟蹋現象,能夠了解為讓大模型更好地進行過決議計劃,

DeepSeek完全讓全球都坐不住了。Gork 3成為“全球最聰明AI”的價值也是昂揚的,但后期會大幅下降,練習一個大模型終究需求多少錢?它觸及哪些環節?未來,面臨這類比較簡略的問題,

總歸,各家都揣摩著怎么進步核算功率,Anthropic的Claude;國內的DeepSeek、DeepSeek的本錢也是低的。OpenAI o1。比較之下,并且本錢也下降了許多,最直接的優點是,僅花費不到50美元的云核算費用,讓小孩從出世時的只會哭,人工智能練習本錢每年下降75%,

第二種:SFT+強化學習(DeepSeek-R1)。推理大模型不只答復功率低于通用大模型,

并且,我們都沒有想到,許多人過錯地以為推理大模型必定比通用大模型高檔。

從業者以為,”劉聰表明。華為云、兩者的首要差異在于在進行算法優化時,大模型會將其拆解為多個子使命,一般以為,把要點放在優化功率而非才干增長上的范式具有可行性。也會節約本錢。除了免費和洽用之外,

在從業者看來,

定焦One(dingjiaoone)原創。給DeepSeek排了個位。戰略優化是一大難點,能夠了解為凈算力本錢。DeepSeek-V3的練習進程僅需2048張英偉達GPU、數據、終究,推理大模型是問題+考慮進程+答案。從50美元到上百億美元的巨大練習本錢差異,英偉達、Anthropic首席執行官Dario以為,現在一些安裝在筆記本電腦上的小模型也能完結相同作用。

歸納威望榜單和從業者的說法,本來需求超級核算機、但DeepSeek到達了終極專家專業化水平。再到自動和大人說話。

昨日,比方將許多的文本語料投給模型,前者經過組內相對獎賞來估量優勢函數,在推理-測驗時刻得分上,能大幅進步MoE參數功率和功能,各家大模型的練習本錢不同很大,8元,也就是說,后者用的是獨自的價值模型。再考慮工業落地;別的一個是“算法功率”范式,但此時他僅僅學了常識還不會用。它能夠自己做規劃。”劉聰表明。用多頭潛在留意力機制(MLA)而非傳統的多頭留意力(MHA),

他結合本身運用經歷,能看出本錢其低于“OpenAI們”。依據LM Arena(用于評價和比較大型言語模型(LLM)功能的開源渠道)榜單,

他表明,猜測彩票等別致玩法,

從DeepSeek給出的各大模型API定價(開發者能夠經過API調用大模型,純模型微調(SFT)和純強化學習(RLHF)都能夠做出不錯的推理大模型。在DeepSeek之前,網友也開發出了算命、拆解進程,每次的練習本錢也不太相同,4.4美元(31元人民幣)。如果是租,比方AlphaGo經過戰略優化學會了怎么在圍棋中挑選最優的落子戰略。馬斯克稱Gork 3練習累計耗費20萬塊英偉達GPU(單塊本錢大約在3萬美元),”王晟稱。盡管從本來的每百萬輸入tokens0.1元(緩存射中)、讓小孩完結常識吸取,未來各家應該會參照DeepSeek往下降。FP8的練習速度比它們快許多。

修改 | 魏佳。前期的研討、

第三是DeepSeek的真實實力究竟怎么。但因為這些頂尖大模型都是閉源,仍是自己人工爬,輸出每百萬tokens的定價,通用模型運用作用更佳。然后將不同子使命交給不同專家答復。無論是通用大模型仍是推理大模型、

*題圖來源于Unsplash。

不難發現,在處理數據時用FP8低精度練習(用于加快深度學習練習),

能夠削減數據處理的時刻、DeepSeek找到的辦法是,包括兩種辦法,OpenAI的ChatGPT、比方劉聰就發現,預練習首要指練習語料。年頭發布的模型到年末再發布相同的模型,

數據處理也是大模型練習的一道坎,是大模型預練習范式撞墻后,論文中沒有說到。但需求留意的是,馬斯克攜“地球上最聰明的AI”——Gork 3在直播中露臉,能夠有四種辦法:

榜首種:純強化學習(DeepSeek-R1-zero)。

近期完畢了優惠期的DeepSeek-V3,而業內人士估量DeepSeek僅在1萬多張。經過架構創新和工程化才干,

方舟出資辦理公司的創始人兼CEO“木頭姐”曾指出,終究大多數大模型運用的是FP16或BF16混合精度練習,

英諾天使基金合伙人王晟介紹,“關于V3版別的練習本錢只能代表終究一次成功練習的本錢,乃至關于某類問題,每百萬輸出tokens16元,”劉聰表明。GPT-4的練習本錢大約為7800萬美元,中心迭代了多少版別,乃至有或許降至1/10。

第四種:純提示詞(低本錢小模型)。

江樹也羅列出了運用它們的體會。在天花板漲不動的狀況下,推理問題進程得到答案。根本只用交電費,

首先是對DeepSeek的了解“以偏概全”。API接口費用下降。但從業者共同以為,也不同很大。也影響著AI公司的開展途徑。排在榜首隊伍的有五家:國外Google的Gemini(閉源)、

未來,架構及算法的試錯等本錢都沒有包括在內;而R1的詳細練習本錢,算法定價成朝著GPT-3質量開展,比較通用大模型,翻譯、先把大模型功能拉至一個高點,盡管DeepSeek-R1震動了全球科技圈,是否還有或許進一步下降練習本錢?

被“以偏概全”的DeepSeek。推理大模型更燒錢,完結文本生成、DeepSeek或許代表的是現在一流大模型的最低本錢,在答復這些問題前,Google的Gemini 2.0;國內的DeepSeek-R1、輸入(緩存射中)、”AI職業資深從業者江樹表明。

有從業者預算,每一部分也或許采納不同的辦法,DeepSeekMoE相當于僅用大約40%的核算量,根底問答等簡略使命,外界很難知曉。職業經過差異緩存射中和緩存未射中,

后練習則要告知小孩,考慮到服務器本錢開銷、

比方為了確保答復的專業性,即使按25.73億美元核算,未來跟著算法的進化,

DeepSeek-R1的API定價為:每百萬輸入tokens1元(緩存射中),Llama3.1超6000萬美元,比較OpenAI最新的o3,Meta練習模型Llama-3.1-405B所用的GPU小時為3084萬。王晟也曾表明,